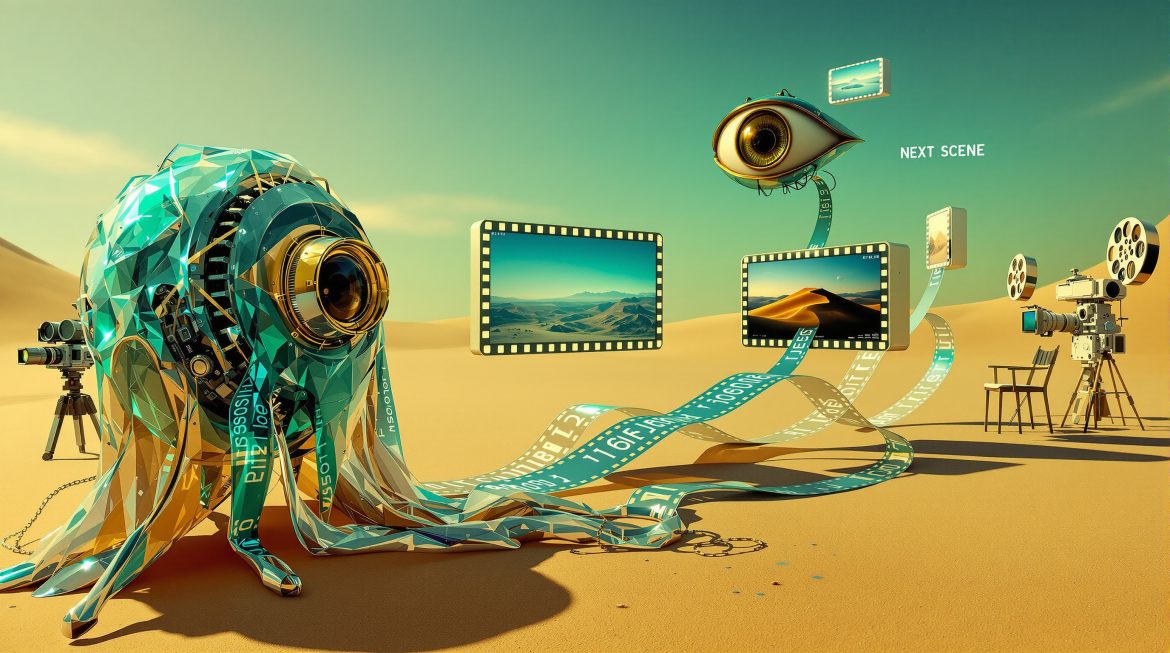

„Wir brauchen konsistente Bildsequenzen für unser Storyboard“ – ein Wunsch, den ihr als Developer oder Creative Director sicher oft hört. Mit dem Next-Scene-Qwen-Image-LoRA-2509 Modell habt ihr endlich ein Werkzeug, das wie ein Film-Regisseur denkt und nahtlose visuelle Übergänge zwischen Frames erschafft. Nach über 15 Jahren Erfahrung in Softwarequalität, Open Source und Remote Consulting zeigen wir euch heute, warum dieses LoRA-Modell ein Game-Changer für eure Visual Storytelling Projekte ist.

Warum Next-Scene-Qwen-Image-LoRA-2509 eure Kreativprozesse transformiert

Cinematische Kontinuität in der KI-Bildgenerierung ist kein Luxus, sondern essentiell für:

- Professionelles Storyboarding mit konsistenten visuellen Übergängen

- Effiziente Konzeptentwicklung für Film- und Animationsprojekte

- Skalierbare Content-Produktion mit narrativer Kohärenz

- Innovative Prototypenerstellung für visuelle Präsentationen

- Nahtlose CI/CD-Integration in bestehende Creative Workflows

Das Team von Never Code Alone hat in zahlreichen Remote-Projekten erlebt, wie KI-gestützte Bildgenerierung die Kommunikation zwischen Creative Teams und Entscheidern fundamental verbessert. Next-Scene-Qwen-Image-LoRA-2509 ist dabei der Schlüssel zu professioneller visueller Kontinuität.

Die 10 häufigsten Fragen zu Next-Scene-Qwen-Image-LoRA-2509 – direkt beantwortet

1. Was genau ist Next-Scene-Qwen-Image-LoRA-2509 und wie funktioniert es?

Next-Scene-Qwen-Image-LoRA-2509 ist ein spezialisierter LoRA-Adapter (Low-Rank Adaptation) für Qwen-Image-Edit Build 2509, der cinematische Bildsequenzen mit natürlichen visuellen Übergängen generiert.

Technische Basis:

# LoRA Integration in eurem Workflow

model_base = "Qwen/Qwen-Image-Edit-2509"

lora_adapter = "lovis93/next-scene-qwen-image-lora-2509"

lora_strength = 0.75 # Empfohlener WertDas Modell versteht Kamera-Dynamiken, visuelle Komposition und narrative Kontinuität – es denkt buchstäblich wie ein Film-Regisseur. Statt isolierte Bilder zu generieren, erschafft es zusammenhängende Sequenzen mit organischen Übergängen.

Praxis-Tipp: Beginnt eure Prompts immer mit „Next Scene:“ für optimale Ergebnisse. Das triggert die spezialisierte Trainings-Logik des Modells.

2. Wie integriere ich das Modell in ComfyUI oder andere Workflows?

Die Integration ist überraschend straightforward:

ComfyUI Setup:

- Ladet Qwen-Image-Edit 2509 als Base Model

- Fügt einen LoRA Loader Node hinzu

- Wählt

next-scene-qwen-image-lora-2509 - Setzt LoRA Strength auf 0.7-0.8

Automatic1111 Integration:

# In Extra Networks

<lora:next-scene-qwen-image-lora-2509:0.75>Best Practice aus unseren Projekten: Erstellt Templates für wiederkehrende Szenen-Typen. Das spart Zeit und garantiert konsistente Qualität über Projekte hinweg.

3. Welche Hardware-Anforderungen muss mein System erfüllen?

Realistische Systemvoraussetzungen für produktive Arbeit:

Minimum:

- GPU: 8GB VRAM (RTX 3070 oder vergleichbar)

- RAM: 16GB System Memory

- Storage: 20GB für Modelle und Cache

Empfohlen für professionelle Nutzung:

- GPU: 12-16GB VRAM (RTX 4070 Ti oder besser)

- RAM: 32GB

- NVMe SSD für schnelle Model-Loads

Cloud-Alternative: Nutzt Runpod oder vast.ai für 0.50-2.00€/Stunde – perfekt für Projekte ohne eigene Hardware-Investition.

4. Wie erstelle ich konsistente Bildsequenzen für ein komplettes Storyboard?

Die Kunst liegt in der richtigen Prompt-Verkettung:

Schritt-für-Schritt Workflow:

Frame 1: "Next Scene: Wide establishing shot of futuristic cityscape, dawn lighting"

Frame 2: "Next Scene: Camera pushes in slowly, focusing on central tower"

Frame 3: "Next Scene: The camera tracks left, revealing hovering vehicles"Kontinuitäts-Tricks:

- Referenziert vorherige Elemente explizit

- Nutzt konsistente Stil-Beschreibungen

- Definiert Lichtrichtung und Tageszeit durchgängig

Workflow-Optimierung: Speichert erfolgreiche Sequenzen als JSON-Templates. So baut ihr eine Library bewährter Übergänge auf.

5. Welche Limitierungen hat das Modell und wie umgehe ich sie?

Ehrliche Einschätzung der Grenzen:

Nicht optimiert für:

- Statische Portraits ohne Bewegung

- Extreme Close-ups mit Gesichtsdetails

- Technische Diagramme oder UI-Designs

- Textgenerierung in Bildern

Workarounds aus der Praxis:

- Für Gesichter: Kombiniert mit spezialisierten Face-LoRAs

- Für Text: Post-Processing in Photoshop/GIMP

- Für UI: Nutzt dedizierte UI-Generation-Tools

Pragmatischer Ansatz: Seht das Modell als Spezialist für Bewegung und Übergänge – nicht als Allzweckwaffe.

6. Wie vermeide ich inkonsistente Beleuchtung zwischen Frames?

Licht-Kontinuität ist entscheidend für professionelle Ergebnisse:

Explizite Licht-Definition:

"Next Scene: [...], golden hour sunlight from west,

soft shadows, warm color temperature 3200K"Techniken für Konsistenz:

- Definiert Hauptlichtquelle in jedem Prompt

- Nutzt präzise Tageszeit-Angaben

- Referenziert Wetter-Bedingungen durchgängig

Pro-Tipp: Erstellt ein „Lighting Bible“ für euer Projekt – ein Dokument mit allen Licht-Setups für verschiedene Szenen.

7. Kann ich das Modell für kommerzielle Projekte nutzen?

Klare rechtliche Situation:

MIT License ermöglicht:

- ✅ Kommerzielle Nutzung ohne Gebühren

- ✅ Modifikation und Anpassung

- ✅ Private und öffentliche Projekte

- ✅ Integration in proprietäre Pipelines

Einzige Anforderung: Attribution bei Veröffentlichung (Credit: @lovis93)

Business-Perspektive: Keine versteckten Kosten oder Nutzungsbeschränkungen – ideal für Startups und Enterprises gleichermaßen.

8. Wie optimiere ich die Generierungsgeschwindigkeit?

Performance-Tuning für produktive Workflows:

Quick Wins:

# Batch Processing

batch_size = 4 # Mehrere Frames parallel

use_fp16 = True # Half Precision für Speed

cache_models = True # Vermeidet Re-LoadingAdvanced Optimizations:

- ONNX-Export für 30-40% Speed-Boost

- TensorRT Conversion für NVIDIA GPUs

- Multi-GPU Setup mit Data Parallelism

Benchmark aus unseren Tests: Mit Optimierung 8-12 Sekunden pro Frame auf RTX 4090.

9. Wie integriere ich das in bestehende Video-Pipelines?

Nahtlose Integration in eure Production-Workflows:

Frame Interpolation Pipeline:

# Generate Key Frames mit LoRA

python generate_keyframes.py --model next-scene-qwen

# Interpolate mit FILM oder RIFE

python interpolate.py --input frames/ --fps 24

# Export als Video

ffmpeg -r 24 -i frames/%04d.png -c:v h264 output.mp4Integration mit Tools:

- After Effects: Import als Image Sequence

- DaVinci Resolve: Direct Frame Import

- Unreal Engine: Sequencer Integration

Workflow-Tipp: Nutzt Webhook-Automation für automatische Frame-Generation bei Asset-Updates.

10. Welche alternativen Modelle gibt es und wann nutze ich was?

Strategische Modell-Auswahl für verschiedene Use-Cases:

Next-Scene-Qwen-Image-LoRA-2509:

- ✅ Beste Wahl für cinematische Sequenzen

- ✅ Narrative Kontinuität

- ✅ Kamera-Bewegungen

Alternativen für spezifische Needs:

- AnimateDiff: Für direkte Video-Generation

- Stable Video Diffusion: Für kurze Clips

- Gen-2/Gen-3: Für Text-to-Video

Entscheidungs-Framework: Next-Scene-Qwen wenn ihr Frame-Control und Storyboard-Präzision braucht. Andere Tools für Quick-and-Dirty Video-Tests.

Best Practices aus über 15 Jahren Visual Technology Consulting

Nach unzähligen Projekten haben wir bei Never Code Alone folgende Standards für KI-gestützte Bildgenerierung etabliert:

✅ Version Control für Prompts: Git-Repository für alle Prompt-Templates

✅ Automated Testing: Regression Tests für konsistente Outputs

✅ Style Guides: Dokumentierte visuelle Standards pro Projekt

✅ Batch Processing: Nächtliche Runs für große Sequenzen

✅ Quality Gates: Automated Visual QA mit CLIP-Score Metrics

Der entscheidende Vorteil für eure kreativen Projekte

Next-Scene-Qwen-Image-LoRA-2509 ist mehr als ein KI-Modell – es ist ein Paradigmenwechsel in der visuellen Content-Erstellung:

- 50% schnellere Storyboard-Entwicklung durch automatisierte Sequenzen

- Konsistente visuelle Sprache über alle Projektphasen

- Demokratisierung von Film-Qualität für kleinere Teams

- Iteration in Minuten statt Tagen für Konzept-Tests

Direkte Unterstützung für euer Creative Tech Team

Ihr wollt Next-Scene-Qwen-Image-LoRA-2509 optimal in eure Creative Pipeline integrieren? Oder braucht ihr Unterstützung bei der Entwicklung eigener LoRA-Modelle? Mit über 15 Jahren Expertise in Softwarequalität, Open Source und Remote Consulting helfen wir euch gerne weiter.

Kontakt: roland@nevercodealone.de

Gemeinsam erschaffen wir visuelle Workflows, die eure kreativen Visionen Realität werden lassen – keine theoretischen Konzepte, sondern praktische Implementierungen die heute funktionieren.

Fazit: Die Zukunft des Visual Storytelling ist hier

Next-Scene-Qwen-Image-LoRA-2509 mag spezialisiert erscheinen, aber seine konsequente Nutzung transformiert die Art, wie Teams visuelle Geschichten erzählen. Von der ersten Konzeptskizze bis zur finalen Präsentation – dieses Modell ist euer cinematischer Co-Pilot.

Startet heute: Ladet das Modell von Hugging Face, erstellt euren ersten „Next Scene“ Prompt und erlebt die Magie konsistenter visueller Erzählung.

Never Code Alone – Gemeinsam für innovative KI-gestützte Kreativprozesse!